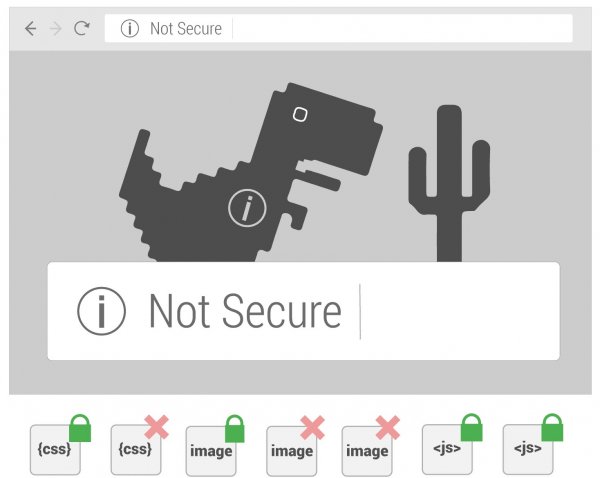

Mixed Content - исправляем с помощью nginx

Опубліковано dl 08.06.2021 09:53Уже достаточно давно браузеры помечают сайты, которые работают не по протоколу HTTPS как "не конфиденциальные". Такое уведомление в строке адреса, конечно, неприятно и портит имидж сайта, даже если на самом деле в данном случае никакая конфиденциальность и не нужна. В связи с этим большинство владельцев и вебмастеров озаботились переводом сайтов на работу по безопасному протоколу, но, во многих случаях возникает проблема смешанного контента ("mixed content"). Изначально браузеры только помечали присутствие смешанного контента на странице, но в последстви стали его просто блокировать. Это привело к неправильному отображению страниц - слетала верстка, скрипты и пр.